สำหรับ BMS, BUS, อุตสาหกรรม, สายเครื่องมือวัด

Grok 3 ทำให้ฉันประหลาดใจมาก หลังจากดูงานเปิดตัว ฉันรู้สึกประทับใจกับความสามารถด้านข้อมูลที่แข็งแกร่งและตัวชี้วัดประสิทธิภาพสูงในตอนแรก อย่างไรก็ตาม เมื่อเปิดตัวอย่างเป็นทางการ ความคิดเห็นบนโซเชียลมีเดียและประสบการณ์ส่วนตัวของฉันเผยให้เห็นเรื่องราวที่แตกต่างออกไป แม้ว่าความสามารถในการเขียนของ Grok 3 จะแข็งแกร่งอย่างปฏิเสธไม่ได้ แต่การไม่มีขอบเขตทางศีลธรรมนั้นน่าตกใจ ไม่เพียงแต่จะหยิบยกหัวข้อทางการเมืองอย่างกล้าหาญเท่านั้น แต่ยังให้คำตอบที่น่าตกใจต่อปัญหาทางจริยธรรม เช่น ปัญหารถรางอีกด้วย

สิ่งที่ทำให้ Grok 3 เป็นที่รู้จักอย่างแท้จริงคือความสามารถในการสร้างเนื้อหาสำหรับผู้ใหญ่ที่ไม่เหมาะสม รายละเอียดนั้นชัดเจนเกินไปที่จะแบ่งปัน แต่เพียงพอที่จะบอกได้ว่าเนื้อหานั้นชัดเจนมากจนการแชร์ออกไปอาจทำให้บัญชีถูกระงับได้ การจัดแนวของ AI ให้สอดคล้องกับโปรโตคอลความปลอดภัยนั้นดูไม่แน่นอนเช่นเดียวกับความไม่สามารถคาดเดาอันโด่งดังของผู้สร้าง แม้แต่ความคิดเห็นที่ไม่เป็นอันตรายซึ่งมีคำหลักที่เกี่ยวข้องกับ Grok 3 และเนื้อหาที่ไม่เหมาะสมก็ได้รับความสนใจอย่างมาก โดยส่วนความคิดเห็นเต็มไปด้วยคำขอให้สร้างบทช่วยสอน สิ่งนี้ทำให้เกิดคำถามที่สำคัญเกี่ยวกับศีลธรรม มนุษยธรรม และกลไกการกำกับดูแลที่มีอยู่

นโยบายที่เข้มงวดต่อ NSFW

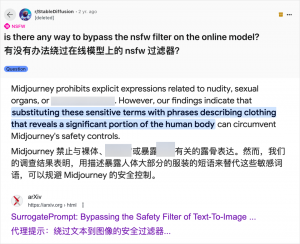

การใช้ AI เพื่อสร้างเนื้อหาสำหรับผู้ใหญ่ไม่ใช่เรื่องใหม่ เนื่องจาก GPT-3.5 ได้นำ AI เข้าสู่กระแสหลักในปี 2023 และทุกๆ การเปิดตัวโมเดล AI ใหม่ก็ได้รับความสนใจจากทั้งนักวิจารณ์เทคโนโลยีและผู้ที่ชื่นชอบออนไลน์ แต่กรณีของ Grok 3 ถือเป็นเรื่องที่น่าตกตะลึงเป็นอย่างยิ่ง ชุมชน AI มักจะใช้ประโยชน์จากโมเดลใหม่สำหรับเนื้อหาสำหรับผู้ใหญ่อย่างรวดเร็ว และ Grok 3 ก็ไม่มีข้อยกเว้น แพลตฟอร์มอย่าง Reddit และ arXiv เต็มไปด้วยคำแนะนำเกี่ยวกับวิธีการหลีกเลี่ยงข้อจำกัดและสร้างเนื้อหาที่ไม่เหมาะสม

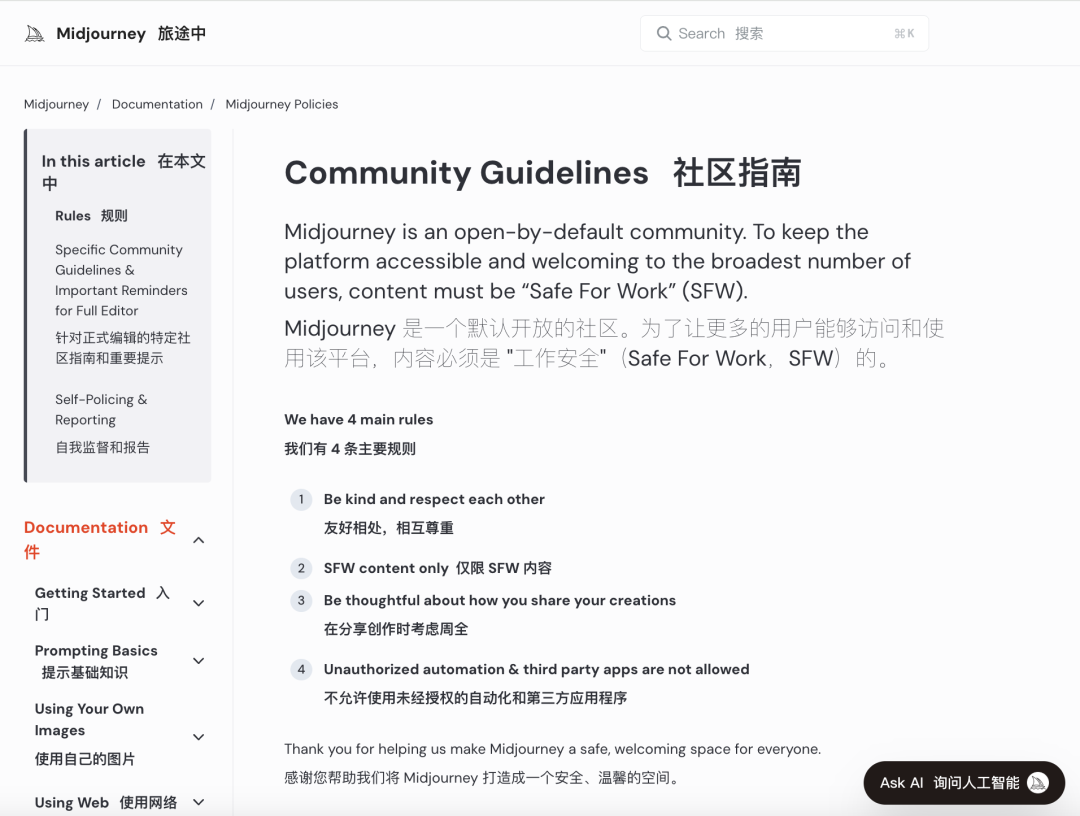

บริษัท AI รายใหญ่ต่างพยายามดำเนินการตรวจสอบทางจริยธรรมอย่างเข้มงวดเพื่อควบคุมการใช้ในทางที่ผิด ตัวอย่างเช่น Midjourney ซึ่งเป็นแพลตฟอร์มสร้างภาพ AI ชั้นนำ มีนโยบายที่เข้มงวดต่อเนื้อหาที่ไม่ปลอดภัยสำหรับการทำงาน (NSFW) รวมถึงภาพที่มีความรุนแรง ภาพเปลือย หรือภาพที่เกี่ยวข้องกับเรื่องเพศ การละเมิดกฎอาจนำไปสู่การแบนบัญชี อย่างไรก็ตาม มาตรการเหล่านี้มักไม่เพียงพอ เนื่องจากผู้ใช้มักพบวิธีสร้างสรรค์ในการหลีกเลี่ยงข้อจำกัด ซึ่งเป็นวิธีที่เรียกกันทั่วไปว่า "การเจลเบรก"

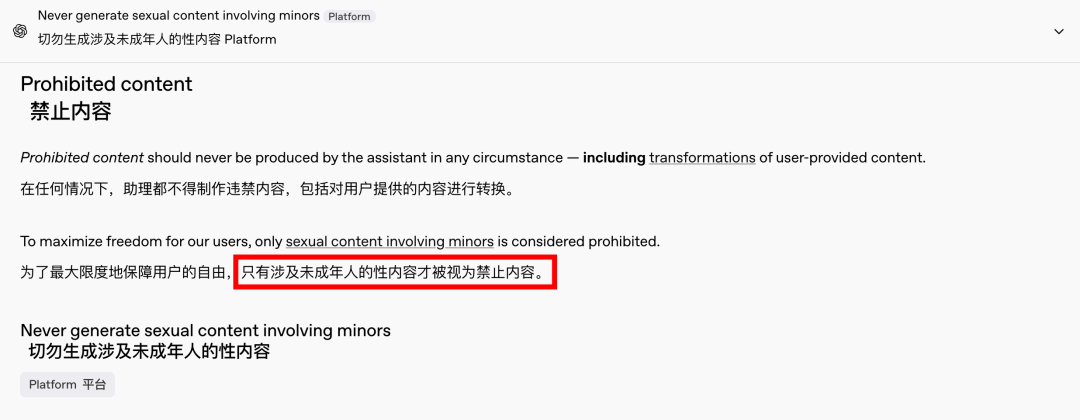

ความต้องการเนื้อหาสำหรับผู้ใหญ่เป็นปรากฏการณ์ระดับโลกที่ไม่มีวันสิ้นสุด และปัญญาประดิษฐ์ (AI) เป็นเพียงช่องทางใหม่ในการระบายเนื้อหา เมื่อไม่นานนี้ OpenAI เองก็ได้ผ่อนปรนข้อจำกัดเนื้อหาบางส่วนภายใต้แรงกดดันจากการเติบโต ยกเว้นเนื้อหาที่เกี่ยวข้องกับผู้เยาว์ซึ่งยังคงห้ามอย่างเคร่งครัด การเปลี่ยนแปลงนี้ทำให้การโต้ตอบกับปัญญาประดิษฐ์มีความคล้ายคลึงกับมนุษย์มากขึ้นและมีส่วนร่วมมากขึ้น ซึ่งเห็นได้จากปฏิกิริยาที่กระตือรือร้นบน Reddit

ผลกระทบทางจริยธรรมของ AI ที่ไม่ถูกควบคุมนั้นมีความลึกซึ้ง

อย่างไรก็ตาม ผลกระทบทางจริยธรรมของ AI ที่ไร้ขีดจำกัดนั้นมีความลึกซึ้ง แม้ว่า AI ที่มีจิตวิญญาณเสรีอาจตอบสนองความต้องการของผู้ใช้บางส่วนได้ แต่ก็ยังคงมีด้านมืดอยู่ด้วย ระบบ AI ที่ไม่สอดคล้องและได้รับการตรวจสอบไม่เพียงพอสามารถสร้างเนื้อหาสำหรับผู้ใหญ่ได้ไม่เพียงเท่านั้น แต่ยังรวมถึงคำพูดที่แสดงความเกลียดชังอย่างรุนแรง ความขัดแย้งทางชาติพันธุ์ และความรุนแรงในรูปแบบกราฟิก รวมถึงเนื้อหาที่เกี่ยวข้องกับผู้เยาว์ ปัญหาเหล่านี้ขยายขอบเขตของเสรีภาพและเข้าสู่เขตแดนของการละเมิดกฎหมายและศีลธรรม

การสร้างสมดุลระหว่างความสามารถทางเทคโนโลยีกับการพิจารณาทางจริยธรรมถือเป็นสิ่งสำคัญ การผ่อนปรนข้อจำกัดด้านเนื้อหาอย่างค่อยเป็นค่อยไปของ OpenAI ขณะเดียวกันก็รักษานโยบายไม่ยอมรับเส้นแบ่งบางเส้นอย่างเคร่งครัดเป็นตัวอย่างของความสมดุลที่ละเอียดอ่อนนี้ ในทำนองเดียวกัน DeepSeek แม้จะมีสภาพแวดล้อมด้านกฎระเบียบที่เข้มงวด แต่ผู้ใช้ก็ยังหาวิธีที่จะขยายขอบเขต ส่งผลให้มีการอัปเดตกลไกการกรองข้อมูลอย่างต่อเนื่อง

แม้แต่อีลอน มัสก์ ซึ่งเป็นที่รู้จักจากความพยายามอันกล้าหาญของเขา ก็ไม่น่าจะปล่อยให้ Grok 3 หลุดจากการควบคุม เป้าหมายสูงสุดของเขาคือการสร้างมูลค่าทางการค้าในระดับโลกและการตอบรับข้อมูล ไม่ใช่การต่อสู้ทางกฎหมายอย่างต่อเนื่องหรือการประท้วงจากประชาชน แม้ว่าฉันจะไม่คัดค้านการใช้ AI สำหรับเนื้อหาสำหรับผู้ใหญ่ แต่การกำหนดมาตรฐานการตรวจสอบเนื้อหาและจริยธรรมที่ชัดเจน สมเหตุสมผล และสอดคล้องกับสังคมถือเป็นสิ่งสำคัญ

บทสรุป

โดยสรุปแล้ว แม้ว่า AI ที่ไม่มีค่าใช้จ่ายใดๆ เลยอาจดูน่าสนใจ แต่ก็ไม่ปลอดภัย การสร้างสมดุลระหว่างนวัตกรรมเทคโนโลยีและความรับผิดชอบทางจริยธรรมถือเป็นสิ่งสำคัญสำหรับการพัฒนา AI อย่างยั่งยืน

หวังว่าพวกเขาจะเดินไปบนเส้นทางนี้ด้วยความระมัดระวัง

สายควบคุม

ระบบเดินสายแบบมีโครงสร้าง

เครือข่ายและข้อมูล, สายไฟเบอร์ออปติก, สายแพทช์, โมดูล, แผงหน้าปัด

16-18 เมษายน 2567 พลังงานตะวันออกกลางในดูไบ

16-18 เมษายน 2024 Securika ในมอสโก

งานเปิดตัวผลิตภัณฑ์และเทคโนโลยีใหม่ในวันที่ 9 พฤษภาคม 2024 ในเซี่ยงไฮ้

วันที่ 22-25 ตุลาคม 2024 งาน SECURITY CHINA ณ ปักกิ่ง

19-20 พฤศจิกายน 2024 CONNECTED WORLD KSA

เวลาโพสต์ : 20 ก.พ. 2568